Ollama可以让用户在服务器上运行各种大型语言模型,如DeepSeek,从而创建个人人工智能代理。本文就以美国主机商Hostinger为例,为大家介绍一下在Hostinger VPS上运行DeepSeek的教程,仅供参考。

一、选购合适的Hostinger VPS主机

在安装Ollama之前,用户需要拥有一个Linux VPS,本文选择的是Hostinger VPS。

- 推荐配置:16GB内存、12GB存储空间、4 CPU内核。

- 操作系统:建议使用Ubuntu和CentOS等流行的Linux发行版。

本文选择的是Hostinger VPS主机KVM 4方案,配置为4核16GB、200GB NVMe硬盘、16TB流量、Linux操作系统,价格低至$9.99/月。

折扣获取页面:Hostinger优惠码(购买时长越长,折扣优惠越大)

Hostinger VPS主机方案推荐

| 方案 | CPU | 内存 | 硬盘 | 流量 | 价格/月 |

| KVM 1 | 1vCPU | 4GB | 50GB NVMe | 4TB | $4.99 |

| KVM 2 | 2vCPU | 8GB | 100GB NVMe | 8TB | $6.99 |

| KVM 4 | 4vCPU | 16GB | 200GB NVMe | 16TB | $9.99 |

| KVM 8 | 8vCPU | 32GB | 400GB NVMe | 32TB | $19.99 |

《点击进入官网选购》

二、在Hostinger VPS上运行DeepSeek

1、安装Ollama

首先使用PuTTY或终端通过SSH连接到用户的VPS主机。

连接后,按照以下步骤安装Ollama:

输入以下命令更新服务器的软件源。如果你使用的是基于Red Hat Enterprise Linux的发行版,如CentOS或AlmaLinux,请用dnf替换apt。

sudo apt update

安装外部依赖项–Ollama正常运行所需的软件。命令如下:

sudo apt install python3 python3-pip python3-venv

输入以下命令下载并设置Ollama:

curl -fsSL https://ollama.com/install.sh | sh

运行以下命令创建Python虚拟环境:

python3 -m venv ~/ollama-webui && source ~/ollama-webui/bin/activate

运行以下命令设置Ollama Web UI:

pip install open-webui

使用Screen启动虚拟终端。即使关闭SSH连接后,Ollama仍会在后台运行。

screen -S Ollama

使用以下命令运行Ollama:

open-webui serve

现在,用户可以在Web b中输入以下地址访问Ollama。切记将185.185.185.185替换为VPS的实际IP地址:

185.185.185.185:8080

2、设置DeepSeek

在确认Ollama可以正常运行之后,设置DeepSeek-R1模型。回到主机系统的命令行界面,按Ctrl+C键停止Ollama。

运行此命令下载DeepSeek-R1模型。本文将使用7b版本:

ollama run deepseek-r1:7b

等待系统完成下载DeepSeek。

下载完成后,按Ctrl+d键返回主shell。然后运行以下命令检查DeepSeek是否配置正确:

ollama list

如果在Ollama LLM表中看到DeepSeek,说明配置成功。现在,重启Web界面:

open-webui serve

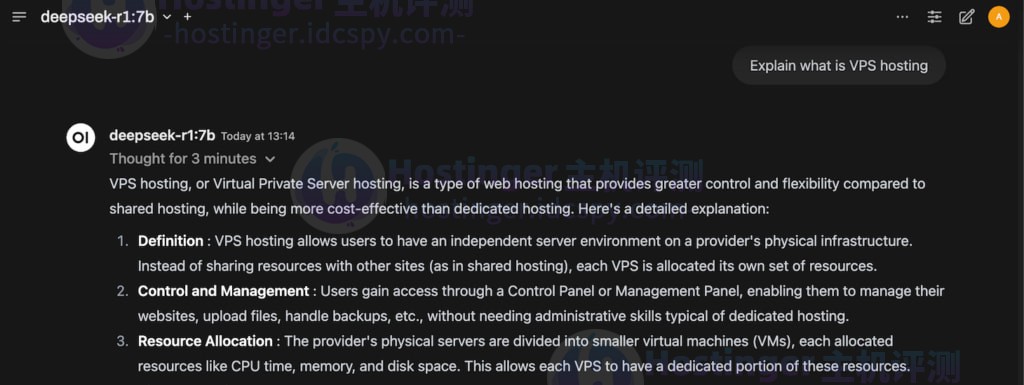

3、在Ollama上测试DeepSeek

访问Ollama GUI并创建一个新账户。

登录后,用户将看到主数据面板,在这里就可以与DeepSeek进行聊天交互了。